完全自動運転に向けた、自動運転車におけるセンシングの課題

新しいセンシング技術は、既存の運転支援システムの成功を基盤とした、完全自動運転車の実現に役立っている。

当初はハイエンドモデルのオプションとしてしか提供されていなかった運転支援技術が、徐々に主流市場において受け入れられつつある。アダプティブクルーズコントロール(車間距離制御装置:ACC)が1990年代に導入された後、カメラやレーダーに基づくブラインドスポットモニタリング(死角検知装置:BSM)、車線制御、自動ブレーキがそれに続いた。自動車のブレーキをかけて後方衝突を防ぐ衝突回避システムは、欧州連合(EU)では2022年5月から新車への搭載が義務付けられ、米国では多くの新型モデルに標準装備されるようになっている。安全性関連のアナリストらは、自動ブレーキによって衝突事故による死者数は、最大20%減少する可能性があると予測している(1)。

そうした機能の装備と強化は、完全自動運転に向けた明らかな道すじであると思われていた。

しかし、2021年8月のアンケート調査で、完全自動運転車に乗りたいと回答した成人はわずか23%で、その3年前の19%よりは増加したものの、未だ不安を感じさせる結果にとどまっている(2)。残念ながら、大々的に報じられた自動運転車による死亡事故が、世間の支持を損なっている。米ウーバー社(Uber)は2020年12月にこの事業から身を引き、同社のロボタクシー開発プログラムを売却した。米ウェイモ社(Waymo)は2021年初頭に、自社の車両を「自動運転車」と呼ぶことを止めた(3)。米テスラ社(Tesla)が2021年に、オートパイロット機能を装備する自動車を90万台以上販売したという明るいニュースにさえも、それらの車両は完全自動運転車ではないという事実と、オートパイロットモードで走行していたテスラ車によって、1人の救急隊員が死亡し、17人が負傷した11件の事故の調査を、米国運輸省道路交通安全局(National Highway Transportation Safety Board:NHTSA)が2021年8月に開始したことが、影を落とした(4)。

自動運転車の目と頭脳をアップグレードする時が来たようだ。

センサと人工知能

目とは、自動車周辺の全方向を監視するセンサで構成されるネットワークで、頭脳とは、保存されたデジタルマップなどのデータに紐づけられた高性能なコンピュータ上で実行する人工知能(AI)システムある。ソフトウエアは、センサデータなどの情報を解析して、歩行者や他の車両を追跡し、その動作を予測し、安全に走行するために自動車が進むべき経路を計算する。

データの収集と処理は、どちらも複雑なリアルタイム操作である。光の伝播時間さえもが重要になる。LiDAR(ライダ)またはレーダーパルスは、1マイクロ秒で光源から目標物までの150mの距離を往復する。主要なセンサは、カメラ、マイクロ波レーダー、ライダだが、多くの自動車がそれ以外にも、超音波を利用して自動駐車を行い、GPS信号を収集してデジタルマップ上の車両の位置を特定する。

システム全体の設計、統合、最適化は複雑である。ロボティクスを手掛ける米パーセプトイン社(PerceptIn)のエンジニアらは2020年に、同社の過去3年間のR&D予算の約半分が、コンピューティングシステムの構築と最適化に費やされたと報告し、次のように述べた。「自動運転には、コンピューティングとセンサの領域にまたがり、新たな設計制約を伴う、無数の異なるタスクで構成されていることがわかった。個々のアルゴリズムの加速化は非常に貴重だが、最終的に重要なのは、体系的な理解と、エンドツーエンドシステムの最適化である」(5)。

運転支援と自動運転のためのカメラ

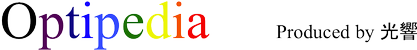

カメラセンサは、十分に開発されていて安価になっており、先進運転支援システム(Advanced Driver Assistance System:ADAS)と自動運転(Automated Driving:AD)システム用に大量に販売されている。すべてにシリコン検出器が採用されているが、細部はシステムの種類や自動車メーカーによって異なる。ADASカメラは、バックミラーの裏に搭載された小さなプロセッサを使用し、ADカメラは、自動車の外周に取り付けられて、車両内部の中央コントローラへのデータリンクを備える。図1は、これら2種類のシステムにおけるカメラの標準的な位置を示している。橙色は、走行車両の前方の危険を検知するためにADASカメラが使用する、広角の主視野領域と挟角の長い視野領域を表している。自動運転車は、車両の360°全方向を網羅するために、側面と後部にもカメラが搭載されており、図には短距離カメラと長距離カメラの視野が示されている。紫色で示されているのは、後方カメラの視野である。

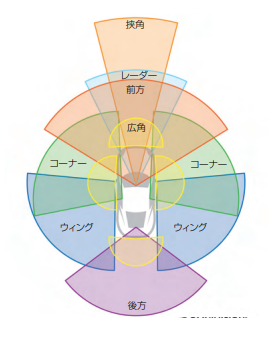

カメラチップの供給メーカーである米オムニビジョン社(Omnivision)のアンディ・ハンビー氏(Andy Hanvey)によると、カメラには、視野とレンジ以外にも数多くの特性が存在するという。自動車には、ADASとAD用のマシンビジョンチップ、サラウンドビューとリアビューカメラのための視覚用チップ、ドライバーを監視するための車内チップという、3種類のカメラが使用されている。それぞれが特定機能向けに最適化されており、検出器アレイは通常、カラー写真用の一般的なRGBパターンであるベイヤー配列(図2a)とは異なるフィルタアレイとなっている。

マシンビジョンチップは、近くにある他の車両や物体の位置や動きの追跡に使われるデータを、AIシステムに供給する。使用される4要素フィルタは、グレースケール処理用に最適化されており、ドライバーに表示するためのものではない。一般的に選択されるのは、1つの赤色要素と3つのクリア要素からなるRCCCフィルタである(図2b)。RCCC画像は、目にはモノクロに見えて、カラー画像を記録することはできない。3つのクリアフィルタによって、感度は最大になり、赤色フィルタは、ブレーキや交通信号の赤い光を識別する。

図1 運転支援と自動運転のための自動車のカメラ配置。(提供:オムニビジョン社)

図1 運転支援と自動運転のための自動車のカメラ配置。(提供:オムニビジョン社)

(もっと読む場合は出典元へ)

出典元

http://ex-press.jp/wp-content/uploads/2022/07/014-017_ft_automotive_sensing.pdf