サーマルイメージングはどのように自動運転センサシステムを改善できるか

自動運転において、畳み込みニューラルネットワークと組み合わせたサーマルイメージングセンサは、利用可能なデータが制限されるときでさえ物体をうまく検出し、分類できる。

自動運転の分野は、費用対効果の高いセンサと改善したコンピューティング能力の出現により、過去10年間でかなりの進歩を遂げた。これらのシステムが一般大衆に採用されるためには、すべての運転条件で人間のドライバーよりも一貫して優れた性能を発揮する必要がある。既存の車両センサは車両の周囲に関する重要な情報を提供するが、これらのセンサが環境を適切に分析せず、衝突につながるケースがいくつか記録されている。

確率論に基づくと、センサシステムが利用できる情報が多ければ多いほど、より正確に測定値を得ることができる。自動運転の場合、これは、より多くの情報が運転環境を適切に認識できるようにし、より洗練された運転の決断につながることを意味する。赤外線(Infrared:IR)カメラ、または熱画像カメラは、現在、商用の自動運転センサシステムでは使用されていない。これらのセンサは、既存の自動運転センサシステムに追加情報を提供し、車両周辺の物体の識別におけるパフォーマンスの向上と運転反応の向上へとつながる。

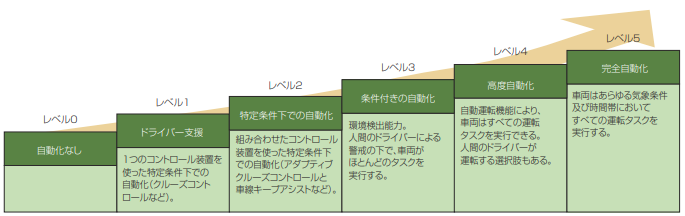

自動車技術者協会(Society of Automotive Engineers:SAE)は、レベル0からレベル5までの6つのレベルの自

動運転を定義している(図1)(1)。現在、ほとんどの主流メーカーはレベル2の自律性に重点を置いている。これには、車線維持支援を備えたアダプティブクルーズコントロールなど、2つの運転プロセスの制御が含まれる。より高いレベルにうまく進むためには、より信頼性の高い環境認識システムが、あらゆる気象条件または時間帯に対応する必要がある。

図1 SAEによって定義される自動運転の6つのレベル。

より高度なセンサシステムの構築

車両の周囲にある物体を特定するには、2つのことが行われる必要がある。物体を検出することと、分類することである。検出は物体が存在することを認識するアクションであり、分類はその物体が正確に何であるかを識別するプロセスである。運転中に物体に気付かないと致命的な結果につながる可能性があるため、自動運転においては、検出は分類よりもはるかに重要であるといえる。また物体が何であるかを正しく分類しないと、交通モデリングにおいて問題が発生する可能性があり、それは適切な車両の反応に影響を及ぼす。

検出と分類を実行するために、車両にはさまざまなセンサが装備されており、各種情報を車両に提供する。自律機能を備えた商用車で使用されている現在のセンサの一式には、超音波、レーダー、ビジョンカメラ、ライダセンサが含まれる。これらのセンサはすべて、車両の周囲に関する独自の情報を提供する。ライダは車両周辺の3D座標点群データを生成し、レーダはその視野内であれば物体の相対的な位置と速度を検出し、カメラは高解像度の2D画像を提供し、超音波センサは近くの物体までの距離を検出できる。それらは一般的に最大10m近くまでだ。ビジョンカメラは車両の近くにある物体の詳細を提供し、物体上の複数のデータポイントしか返さない低解像度センサよりも、物体の分類に優れている。

米テスラ社(Tesla)の「オートパイロット」(物議を醸している自動運転機能(2))は、ビジョンカメラ、レーダ、超音波センサのみを組み合わせて使用する(3)。多くのテスラ車両は、後で物体の識別の精度を上げ改善するために使用できるデータも収集する(4)。これらのセンサとトレーニングされたアルゴリズムは多くの状況でうまく機能するが、膨大な量のセンサデータは、他のセンサによって提供される代替情報を置き換えることはできない。

(もっと読む場合は出典元へ)

出典元

http://ex-press.jp/wp-content/uploads/2021/11/030-032_ft_thermal_imaging.pdf