データセットが、自動運転車へのサーマルイメージングシステムの搭載を促進

サーマル(遠赤外線)センサのデータセットは、暗闇や霧や眩しい太陽光のなかで、より安全かつ効率的に機能するADASや無人車両システムを構築する能力を、自動車コミュニティに提供する。

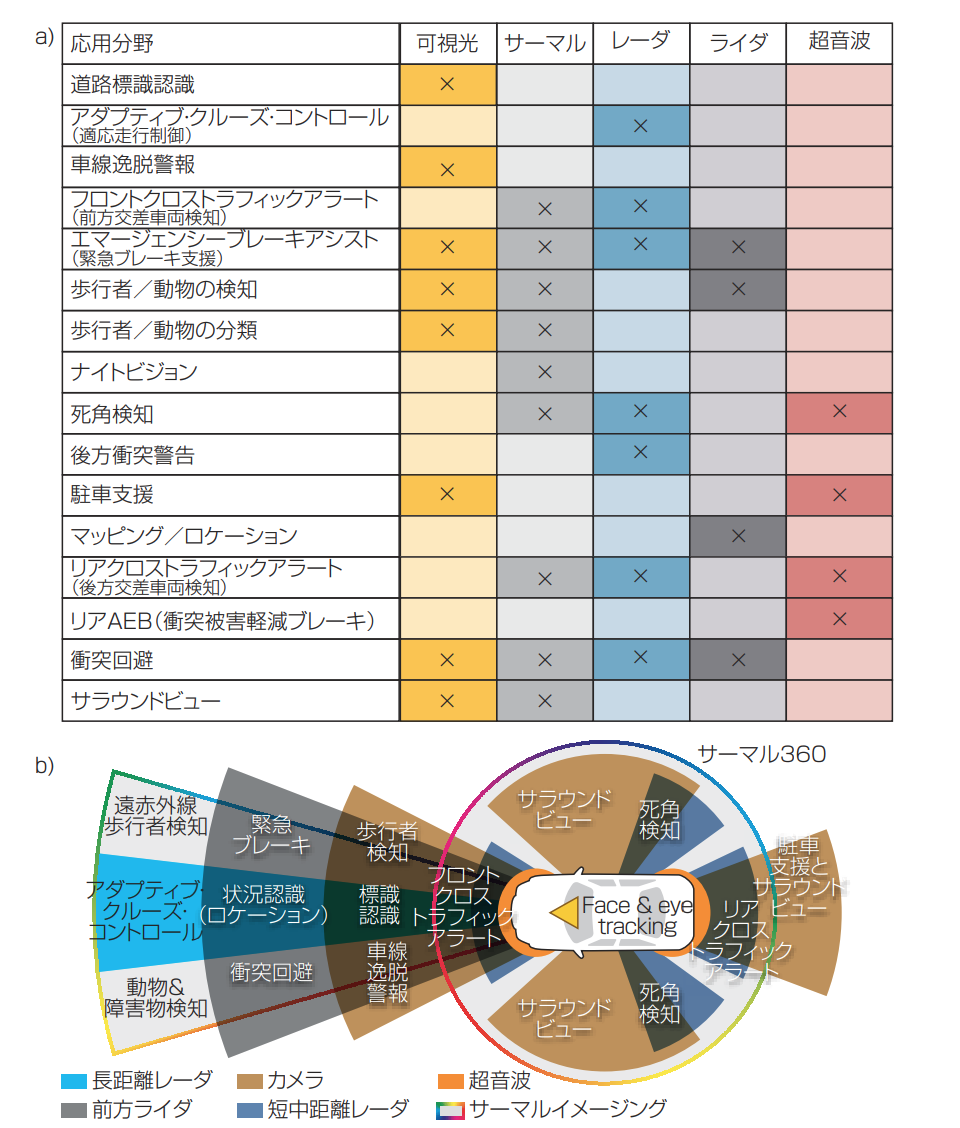

先進運転支援システム(ADAS:Advanced Driver Assistance System)は、アダプティブ・クルーズ・コントロール(ACC:Adaptive Cruise Control)、車線逸脱警報(LDW:Lane Depar ture Warning)、自動駐車、衝突警告・回避などの機能を通して、車両の安全性を向上させる(図1)。自動車メーカーはADASの進歩を、SAE(Socie ty of Automotive Engineers)の自動運転レベル4(特定の場所でシステムがすべてを操作)や5(完全自動運転)を達成するための拠り所にしている。しかし、ADASを実現するセンサ群(一般 的 には、 可 視 光カメラ、 ライダ[lidar:light detection and ranging、光検出と測距]、レーダセンサ)は、暗闇、霧、埃、眩しい太陽光に弱いという欠点がある。これらの欠点が、SAEレベル5を満たす完全自動運転車(AV:Autonomous Vehicle)の開発を遅らせる要因となっている。

ADASやAVシステムをめぐる最近の事故は、現行のセンサ群に加えて、画像認識に基づくデータ処理を実行する畳み込みニューラルネットワークの性能を改善し、冗長性を持たせることの必要性を指し示している。夜間運転警告システム用に50万台を超える車両にすでに実装されている手頃な価格のサーマルセンサを搭載することにより、メーカーは車両の安全性を高めることができる。

サーマル(遠赤外線)または長波長赤外線(LWIR:longwave infrared)カメラや物体検知器は、暗闇や、霧が発生しているほとんどの条件下で、歩行者、車両、動物、自転車を検知して分類することができ、眩しい太陽光の影響を受けない。ADASのセンサ群にサーマルカメラを追加することにより、状況認識が高まり、ADASまたはAVシステムの堅牢性と信頼性と安全性が高まる。しかし、センサを追加すると生成されるデータが増加し、ADASやAVの開発者は、その処理の問題に悩まされることになる。

図1 先進運転支援システム(ADAS)と完全自動運転車(AV)システムは、動く車両(b)に配置されたさまざまな光電子センサ(a)に依存して、搭乗者の安全を確保する。

ADASセンサ群の概要

ADASをSAEのレベル4または5で、高い信頼性で動作させるには、1)センサそのもの、2) コンピューティング能力、3) インテリジェンスを実現するアルゴリズムという3つの重要な技術が必要である。車両の周囲に関する動的データを提供するセンサ群(カメラ、ライダ、レーダなど)は、膨大な量のデータを生成し、高性能な画像処理を実行するための十分なコンピューティング能力が必要となる。GPU(Graphics Processing Unit)が、演算の大部分を実行し、堅牢なソフトウエアアルゴリ

ズムが、意思決定に使われる処理済みデータを提供するために不可欠である。最もよく使われるディープラーニングフレームワークは、TensorFlowとCafféで、最もよく使われる畳み込みニューラルネットワーク(CNN:Convolutional Neural Network)としては、Inception、MobilNet、VGG、Resnetがある。

ADASやAVのプロトタイプが路上に出て、走行距離を累積していくにつれて、現行のセンサ技術の限界がより顕著になり、痛ましい事故も発生している。2018年3月18日、米ウーバー社(Uber)の自動運転車が、夜間に歩行者をはねて死亡させた。別の事故では、米テスラ社(Tesla)の「Model S」がオートパイロットシステムで走行中に、眩しい太陽光の下で道路を横切る白色のトレーラーを認識できず、トラックに衝突した。

これらはコーナーケース(境界ギリギリの特殊なケース)ではなく、サーマルイメージングは、視界を妨げる光を受ける場合や夜間など、見通しの悪い運転条件下での状況認識を高めるための重要なセンサソリューションとして、ますますみなされるようになっている。

(もっと読む場合は出典元へ)

出典元

http://ex-press.jp/wp-content/uploads/2019/05/040pa.pdf